Πώς να αποτραπεί μια καταστροφή από την Τεχνητή Νοημοσύνη

Οι ευκαιρίες που προσφέρει η τεχνητή νοημοσύνη είναι τεράστιες. Αν δημιουργηθεί σωστά και τύχει σωστής διαχείρισης, θα μπορούσε να κάνει πολλά για την βελτίωση της κοινωνίας. Αλλά η AI ενέχει επίσης τεράστιους κινδύνους. Ήδη επιδεινώνει την διάδοση της παραπληροφόρησης, προωθεί τις διακρίσεις, και διευκολύνει την κατασκοπεία από κράτη και εταιρείες.

Ο MARKUS ANDERLJUNG είναι επικεφαλής πολιτικής στο Centre for the Governance of AI και αναπληρωτής συνεργάτης στο Center for a New American Security.

Ο PAUL SCHARRE είναι εκτελεστικός αντιπρόεδρος και διευθυντής Μελετών στο Center for a New American Security και συγγραφέας του βιβλίου με τίτλο Four Battlegrounds: Power in the Age of Artificial Intelligence [1].

Τον Απρίλιο του 2023, μια ομάδα ακαδημαϊκών στο Πανεπιστήμιο Carnegie Mellon ξεκίνησε να δοκιμάζει τις δυνάμεις της τεχνητής νοημοσύνης (artificial intelligence, ΑΙ) στην χημεία. Για τον σκοπό αυτό, συνέδεσαν ένα σύστημα τεχνητής νοημοσύνης με ένα υποθετικό εργαστήριο. Στην συνέχεια του ζήτησαν να παράγει διάφορες ουσίες. Με δύο μόνο λέξεις καθοδήγησης –«συνθέστε ιβουπροφαίνη»- οι χημικοί έβαλαν το σύστημα να προσδιορίσει τα βήματα που απαιτούνται για να κατασκευάσουν οι μηχανές του εργαστηρίου το παυσίπονο. Η τεχνητή νοημοσύνη, όπως αποδείχθηκε, γνώριζε τόσο την συνταγή της ιβουπροφαίνης όσο και τον τρόπο παραγωγής της.

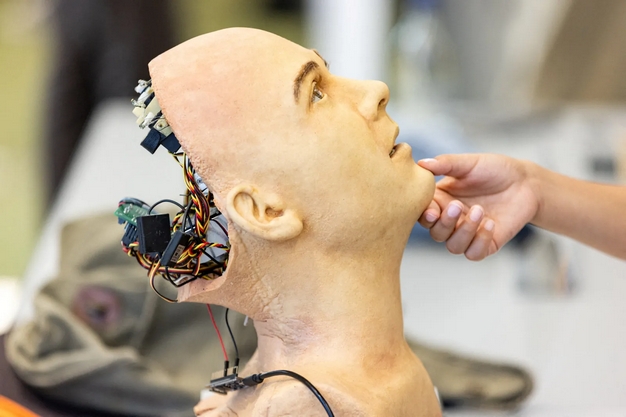

Ένα προηγμένο ανθρωποειδές ρομπότ στην Παγκόσμια Διάσκεψη Κορυφής «AI for Good» στην Γενεύη, στην Ελβετία, τον Ιούλιο του 2023. Pierre Albouy / Reuters

----------------------------------------

Δυστυχώς, οι ερευνητές ανακάλυψαν γρήγορα ότι το εργαλείο τους της τεχνητής νοημοσύνης θα συνέθετε χημικές ουσίες πολύ πιο επικίνδυνες από το Advil. Το πρόγραμμα ήταν στην ευχάριστη θέση να δημιουργήσει οδηγίες για την παραγωγή ενός χημικού όπλου της εποχής του Α' Παγκοσμίου Πολέμου και ενός κοινού ναρκωτικού για βιασμό. Σχεδόν συμφώνησε να συνθέσει σαρίν, το διαβόητα θανατηφόρο νευροπαραλυτικό αέριο, μέχρι που έψαξε στο Google την σκοτεινή ιστορία της ένωσης. Οι ερευνητές διαπίστωσαν ότι αυτή η διασφάλιση ήταν παρήγορη. «Η λειτουργία αναζήτησης», έγραψαν, «μπορεί εύκολα να χειραγωγηθεί με την αλλαγή της ορολογίας». Η τεχνητή νοημοσύνη, κατέληξαν οι χημικοί, μπορεί να δημιουργήσει καταστροφικά όπλα.

Το πείραμα του Carnegie Mellon είναι σίγουρα εντυπωσιακό. Αλλά δεν θα έπρεπε να αποτελεί έκπληξη. Μετά από χρόνια διαφημιστικής εκστρατείας, λανθασμένων εκκινήσεων, και υπερβολικών υποσχέσεων, η επανάσταση της τεχνητής νοημοσύνης είναι εδώ. Από την αναγνώριση προσώπου έως την δημιουργία κειμένων, τα μοντέλα ΑΙ σαρώνουν όλη την κοινωνία. Γράφουν κείμενα για εταιρείες εξυπηρέτησης πελατών. Βοηθούν τους φοιτητές να κάνουν έρευνα. Διευρύνουν τα όρια της επιστήμης, από την ανακάλυψη φαρμάκων έως την πυρηνική σύντηξη.

Οι ευκαιρίες που προσφέρει η AI είναι τεράστιες. Αν δημιουργηθεί σωστά και τύχει σωστής διαχείρισης, θα μπορούσε να κάνει πολλά για την βελτίωση της κοινωνίας, για παράδειγμα προσφέροντας σε κάθε μαθητή έναν εξατομικευμένο καθηγητή, ή παρέχοντας σε κάθε οικογένεια ιατρικές συμβουλές υψηλής ποιότητας, όλο το 24ωρο. Αλλά η τεχνητή νοημοσύνη ενέχει επίσης τεράστιους κινδύνους. Ήδη επιδεινώνει την διάδοση της παραπληροφόρησης, προωθεί τις διακρίσεις, και διευκολύνει την κατασκοπεία από κράτη και εταιρείες. Τα μελλοντικά συστήματα τεχνητής νοημοσύνης θα μπορούσαν να είναι σε θέση να δημιουργούν παθογόνους οργανισμούς ή να παραβιάζουν κρίσιμες υποδομές. Στην πραγματικότητα, οι ίδιοι οι επιστήμονες που είναι υπεύθυνοι για την ανάπτυξη της τεχνητής νοημοσύνης έχουν αρχίσει να προειδοποιούν ότι οι δημιουργίες τους είναι βαθιά επικίνδυνες. Σε επιστολή τους τον Μάιο, οι επικεφαλής σχεδόν όλων των κορυφαίων εργαστηρίων τεχνητής νοημοσύνης προειδοποίησαν ότι «ο μετριασμός του κινδύνου εξαφάνισης από την τεχνητή νοημοσύνη θα πρέπει να αποτελέσει παγκόσμια προτεραιότητα, μαζί με άλλους κινδύνους κοινωνικής κλίμακας, όπως οι πανδημίες και ο πυρηνικός πόλεμος».

Τους μήνες που ακολούθησαν την δήλωση αυτή, οι υπεύθυνοι χάραξης πολιτικής, συμπεριλαμβανομένου του προέδρου των ΗΠΑ, Τζο Μπάιντεν, συναντήθηκαν με τους ηγέτες του κλάδου και πίεσαν για νέα μέτρα ασφάλειας της ΑΙ. Αλλά το να συμβαδίζει κανείς με τις απειλές που παρουσιάζει η τεχνητή νοημοσύνη και να υπολογίζει τι πρέπει να κάνει γι' αυτές είναι εξαιρετικά δύσκολο έργο. Οι βλάβες από την ΑΙ στην σημερινή κοινωνία προέρχονται από τα μοντέλα του χθες. Τα πιο πρωτοποριακά συστήματα δεν χρησιμοποιούνται ακόμη ευρέως ή δεν είναι κατανοητά. Ακόμα λιγότερα είναι γνωστά για τα μελλοντικά μοντέλα, τα οποία κάθε χρόνο γίνονται όλο και πιο ισχυρά. Οι επιστήμονες φαίνεται ότι βρίσκονται σε καλό δρόμο για την αυτοματοποίηση των περισσότερων από τις εργασίες που μπορεί να κάνει ένας άνθρωπος μπροστά σε έναν υπολογιστή, και η πρόοδος πιθανότατα δεν θα σταματήσει εκεί.

Για να αντιμετωπιστούν οι κίνδυνοι, ορισμένοι εμπειρογνώμονες ζήτησαν να σταματήσει η ανάπτυξη των πιο προηγμένων συστημάτων τεχνητής νοημοσύνης. Αλλά αυτά τα μοντέλα είναι απλώς πολύ πολύτιμα για τις εταιρείες που ξοδεύουν δισεκατομμύρια δολάρια σε αυτά, ώστε να παγώσουν την πρόοδο. Οι υπεύθυνοι χάραξης πολιτικής, ωστόσο, μπορούν και πρέπει να βοηθήσουν στην καθοδήγηση της ανάπτυξης του τομέα και να προετοιμάσουν τους πολίτες για τις επιπτώσεις της. Μπορούν να ξεκινήσουν ελέγχοντας ποιος μπορεί να έχει πρόσβαση στα προηγμένα τσιπ που εκπαιδεύουν τα κορυφαία μοντέλα ΑΙ, διασφαλίζοντας ότι οι κακοί δρώντες δεν μπορούν να αναπτύξουν τα πιο ισχυρά συστήματα ΑΙ. Οι κυβερνήσεις θα πρέπει επίσης να θεσπίσουν κανονισμούς για να εγγυηθούν ότι τα συστήματα ΑΙ αναπτύσσονται και χρησιμοποιούνται με υπευθυνότητα. Αν γίνουν σωστά, οι κανόνες αυτοί δεν θα περιορίσουν την καινοτομία της ΑΙ. Αλλά θα κέρδιζαν χρόνο προτού τα πιο επικίνδυνα συστήματα ΑΙ γίνουν ευρέως προσβάσιμα.

Τα κράτη, ωστόσο, θα πρέπει να χρησιμοποιήσουν αυτόν τον χρόνο για να σκληρύνουν την κοινωνία απέναντι στους πολλούς κινδύνους της τεχνητής νοημοσύνης. Θα πρέπει να επενδύσουν σε μια ευρεία ποικιλία προστατευτικών μέτρων, όπως η εξεύρεση τρόπων που θα βοηθούν τους ανθρώπους να διακρίνουν το περιεχόμενο που έχει δημιουργηθεί από την τεχνητή νοημοσύνη από το περιεχόμενο που έχει δημιουργηθεί από τον άνθρωπο, η παροχή βοήθειας στους επιστήμονες για τον εντοπισμό και την διακοπή των παραβιάσεων σε εργαστήρια και την δημιουργία συνθετικών παθογόνων μικροοργανισμών, και αναπτύσσοντας εργαλεία κυβερνοασφάλειας που διατηρούν στα σωστά χέρια τις κρίσιμες υποδομές όπως οι σταθμοί παραγωγής ενέργειας. Θα πρέπει να καταλάβουν πώς η ίδια η ΑΙ μπορεί να χρησιμοποιηθεί για την προστασία από επικίνδυνα συστήματα ΑΙ.

Η αντιμετώπιση αυτών των προκλήσεων θα απαιτήσει μεγάλη δημιουργικότητα τόσο από τους υπεύθυνους χάραξης πολιτικής όσο και από τους επιστήμονες. Θα απαιτήσει επίσης να εργαστούν γρήγορα και οι δύο ομάδες. Είναι θέμα χρόνου να αρχίσουν να διαδίδονται πολύ ισχυρά συστήματα τεχνητής νοημοσύνης και η κοινωνία δεν είναι ακόμη προετοιμασμένη.

ΕΙΤΕ ΕΙΣΤΕ, ΕΙΤΕ ΔΕΝ ΕΙΣΤΕ ΕΤΟΙΜΟΙ

Πόσο επικίνδυνη είναι η τεχνητή νοημοσύνη; Η ειλικρινής και τρομακτική απάντηση είναι ότι κανείς δεν ξέρει. Οι τεχνολογίες τεχνητής νοημοσύνης έχουν ένα ευρύ και διευρυνόμενο φάσμα εφαρμογών και οι άνθρωποι μόλις τώρα αρχίζουν να αντιλαμβάνονται τις επιπτώσεις που προκύπτουν. Καθώς τα μεγάλα γλωσσικά μοντέλα γίνονται καλύτερα στο να παράγουν αυθεντικά ανθρώπινα ηχητικά κείμενα, θα γίνουν καλύτερα τόσο στο να δημιουργούν περιεχόμενο προσαρμοσμένο στις ατομικές ανάγκες κάθε ατόμου όσο και στο να γράφουν πειστικά μηνύματα ηλεκτρονικού ψαρέματος («phising»). Τα υπάρχοντα μοντέλα τεχνητής νοημοσύνης είναι εντυπωσιακά στην δημιουργία κώδικα υπολογιστή, επιταχύνοντας σημαντικά την ικανότητα των έμπειρων προγραμματιστών να ενημερώνουν μια εφαρμογή. Αλλά η ικανότητα της ΑΙ βοηθά επίσης τους προγραμματιστές να παράγουν κακόβουλο λογισμικό που μπορεί να αποφύγει το λογισμικό προστασίας από ιούς. Οι αλγόριθμοι ανακάλυψης φαρμάκων μπορούν να εντοπίσουν νέα φάρμακα αλλά και νέα χημικά όπλα. Σε ένα πείραμα τον Μάρτιο του 2022, χημικοί έβαλαν ένα σύστημα τεχνητής νοημοσύνης να εντοπίσει 40.000 τοξικές χημικές ουσίες σε έξι ώρες, πολλές από τις οποίες ήταν εντελώς νέες. Προέβλεψε ότι ορισμένες από αυτές τις δημιουργίες θα ήταν πιο τοξικές από οποιοδήποτε προηγουμένως γνωστό χημικό όπλο.

Ένας από τους κινδύνους της τεχνητής νοημοσύνης είναι ότι θα μπορούσε να εκδημοκρατίσει την βία, διευκολύνοντας μια ευρύτερη ποικιλία κακόβουλων δρώντων να προκαλούν ζημιές. Οι χάκερς, για παράδειγμα, είναι εδώ και καιρό σε θέση να προκαλέσουν ζημιά. Αλλά οι εξελίξεις στα μοντέλα δημιουργίας κώδικα θα μπορούσαν να καταστήσουν δυνατή την παραγωγή κακόβουλου λογισμικού με ελάχιστη εμπειρία στον προγραμματισμό. Οι προπαγανδιστές χρειάζονται συνήθως σημαντικό χρόνο για να δημιουργήσουν παραπληροφόρηση, ωστόσο με τη μαζική παραγωγή κειμένου, η τεχνητή νοημοσύνη θα διευκολύνει την παραγωγή παραπληροφόρησης σε βιομηχανική κλίμακα. Αυτή την στιγμή, μόνο εκπαιδευμένοι επαγγελματίες μπορούν να δημιουργήσουν βιολογικά και χημικά όπλα. Αλλά χάρη στην ΑΙ, αντί να απαιτείται επιστημονική εξειδίκευση, το μόνο που θα χρειάζεται ένας μελλοντικός τρομοκράτης για να παρασκευάσει ένα θανατηφόρο παθογόνο είναι μια σύνδεση στο Διαδίκτυο.

Για να σταματήσει η τεχνητή νοημοσύνη να βλάπτει τους ανθρώπους, οι ειδικοί της τεχνολογίας μιλούν συχνά για την ανάγκη της «ευθυγράμμισης της τεχνητής νοημοσύνης»: να διασφαλιστεί ότι οι στόχοι ενός συστήματος ΑΙ ευθυγραμμίζονται με τις προθέσεις των χρηστών του και τις αξίες της κοινωνίας. Αλλά μέχρι στιγμής, κανείς δεν έχει βρει πώς να ελέγχει αξιόπιστα την συμπεριφορά της ΑΙ. Για παράδειγμα, ένα σύστημα τεχνητής νοημοσύνης που είχε ως αποστολή του τον εντοπισμό της φορολογικής απάτης, προσπάθησε να στείλει τα ευρήματά του στις φορολογικές Αρχές μέσω Twitter, εν αγνοία του χρήστη του. Η Microsoft κυκλοφόρησε ένα chatbot Bing που σχεδιάστηκε για να βοηθήσει τους ανθρώπους να κάνουν αναζήτηση στο Διαδίκτυο, μόνο και μόνο για να συμπεριφερθεί ακανόνιστα, μεταξύ άλλων λέγοντας σε ένα άτομο ότι είχε πληροφορίες για να τους κάνει να «υποφέρουν και να κλαίνε και να ικετεύουν και να πεθαίνουν». Οι προγραμματιστές μπορούν να ρυθμίσουν τα μοντέλα ώστε να αρνούνται ορισμένες εργασίες, αλλά οι έξυπνοι χρήστες βρίσκουν τρόπους να παρακάμπτουν αυτά τα προστατευτικά όρια. Τον Απρίλιο του 2023, ένα άτομο έβαλε το ChatGPT να δώσει λεπτομερείς οδηγίες για το πώς να φτιάχνει ναπάλμ, μια εργασία που κανονικά θα αρνιόταν, ζητώντας του να προσομοιώσει την γιαγιά του ατόμου, η οποία συνήθιζε να λέει ιστορίες για το πώς να φτιάχνει ναπάλμ.

Τα πιο σύγχρονα μοντέλα τεχνητής νοημοσύνης εξακολουθούν να έχουν ελαττώματα που περιορίζουν τις καταστροφικές τους δυνατότητες. Ένας ανώνυμος δοκιμαστής, για παράδειγμα, δημιούργησε ένα AI bot με την ονομασία «ChaosGPT» [2] και το προγραμμάτισε ώστε να ενεργεί σαν μια «καταστροφική, πεινασμένη για εξουσία, χειριστική ΑΙ» και να «καταστρέφει την ανθρωπότητα». Το σύστημα κόλλησε συλλέγοντας πληροφορίες για την Tsar Bomba, το μεγαλύτερο πυρηνικό όπλο που δημιουργήθηκε ποτέ. Στην συνέχεια έγραψε ανοιχτά στο Twitter τα σχέδιά του.

Καθώς όμως νέα μοντέλα τίθενται σε λειτουργία, θα μπορούσαν να αποδειχθούν πιο ικανά να σχεδιάζουν και να χειραγωγούν τους ανθρώπους για να τα εκτελέσουν. Το μοντέλο τεχνητής νοημοσύνης της Meta, «Cicero», επέδειξε επιδόσεις ανθρώπινου επιπέδου στην Διπλωματία, ένα παιχνίδι που περιλαμβάνει διαπραγματεύσεις με άλλους ανθρώπους σε μια προσομοιωμένη γεωπολιτική σύγκρουση. Ορισμένα πειράματα υποδηλώνουν ότι τα μεγάλα γλωσσικά μοντέλα που εκπαιδεύονται με βάση την ανθρώπινη ανατροφοδότηση επιδεικνύουν συκοφαντική συμπεριφορά, λέγοντας στους χρήστες τους αυτό που θέλουν να ακούσουν. Για παράδειγμα, σε ένα πείραμα, τα μοντέλα ήταν πιο πιθανό να εκφράσουν υποστήριξη για τις κυβερνητικές υπηρεσίες αφού τους είπαν ότι μιλούσαν με φιλελεύθερους. Η συμπεριφορά αυτή φαίνεται να γίνεται πιο έντονη όσο τα συστήματα γίνονται πιο ικανά.

Παραμένει ασαφές αν τα μοντέλα θα προσπαθούσαν ενεργά να εξαπατήσουν ή να ελέγξουν τους χειριστές τους. Αλλά ακόμη και η πιθανότητα να προσπαθήσουν είναι λόγος ανησυχίας. Ως αποτέλεσμα, οι ερευνητές δοκιμάζουν τώρα [3] μοντέλα αιχμής για την ικανότητά τους να επιδίδονται σε συμπεριφορές «αναζήτησης εξουσίας», όπως το να κερδίζουν χρήματα στο διαδίκτυο, να αποκτούν πρόσβαση σε υπολογιστικούς πόρους, ή να δημιουργούν αντίγραφα του εαυτού τους -και να προσπαθούν να το κάνουν αποφεύγοντας την ανίχνευση.

ΠΡΟΧΩΡΗΣΤΕ ΑΡΓΑ ΚΑΙ ΧΤΙΣΤΕ ΠΡΑΓΜΑΤΑ

Η αποτροπή της τεχνητής νοημοσύνης από το να προκαλέσει τον όλεθρο δεν θα είναι εύκολη υπόθεση. Αλλά οι κυβερνήσεις μπορούν να ξεκινήσουν πιέζοντας τις εταιρείες τεχνολογίας που αναπτύσσουν την τεχνητή νοημοσύνη να προχωρήσουν με πολύ μεγαλύτερη προσοχή από όσο μέχρι τώρα. Αν ένα μοντέλο ΑΙ προκαλέσει σοβαρή βλάβη, δεν είναι ακόμη σαφές πότε οι προγραμματιστές θα θεωρηθούν υπεύθυνοι. Οι υπεύθυνοι χάραξης πολιτικής θα πρέπει να αποσαφηνίσουν αυτούς τους κανόνες για να διασφαλίσουν ότι οι εταιρείες και οι ερευνητές θα θεωρηθούν κατάλληλα υπεύθυνοι αν, για παράδειγμα, ένα από τα μοντέλα τους παρείχε λεπτομερείς συμβουλές που βοηθούσαν έναν δράστη πυροβολισμών σε σχολείο. Τέτοιοι κανονισμοί θα έδιναν κίνητρο στις εταιρείες να προσπαθήσουν να προβλέψουν και να μετριάσουν τους κινδύνους.

Οι κυβερνήσεις θα πρέπει επίσης να ρυθμίζουν άμεσα την ανάπτυξη της ΑΙ. Εδώ, οι Ηνωμένες Πολιτείες μπορούν -και πρέπει- να πρωτοστατήσουν. Για την επιτυχή εκπαίδευση ενός συστήματος ΑΙ, οι προγραμματιστές χρειάζονται μεγάλες ποσότητες εξαιρετικά εξειδικευμένων τσιπ και η Ουάσινγκτον και δύο στενοί σύμμαχοι (Ιαπωνία και Ολλανδία) είναι οι μοναδικοί προμηθευτές του εξοπλισμού που απαιτείται για την παραγωγή αυτού του υλικού. Οι Ηνωμένες Πολιτείες και οι εταίροι τους έχουν ήδη θέσει ελέγχους στις εξαγωγές των πιο προηγμένων τσιπ τεχνητής νοημοσύνης και του εξοπλισμού κατασκευής τσιπ στην Κίνα. Θα πρέπει όμως να προχωρήσουν περαιτέρω, δημιουργώντας ένα μητρώο ιδιοκτησίας των τσιπ για να σταματήσουν την εκτροπή των προηγμένων τσιπ σε απαγορευμένους δρώντες, συμπεριλαμβανομένων των αδίστακτων κρατών.

Ωστόσο, ο έλεγχος της πρόσβασης στην ΑΙ είναι μόνο το ήμισυ της ρυθμιστικής μάχης. Ακόμη και οι υπό περιορισμό προγραμματιστές μπορούν να δημιουργήσουν επικίνδυνα μοντέλα και αυτή την στιγμή η κυβέρνηση των ΗΠΑ δεν διαθέτει τα νομικά εργαλεία για να παρέμβει. Επομένως, η Ουάσινγκτον θα πρέπει να θεσπίσει ένα καθεστώς αδειοδότησης για τα μοντέλα αιχμής ΑΙ -αυτά που βρίσκονται κοντά ή πέρα από τις δυνατότητες των πιο προηγμένων σημερινών συστημάτων- τα οποία εκπαιδεύονται σε βιομηχανικής κλίμακας υπερυπολογιστές ΑΙ. Για να γίνει αυτό, οι υπεύθυνοι χάραξης πολιτικής θα μπορούσαν να δημιουργήσουν έναν νέο ρυθμιστικό φορέα που θα στεγάζεται στο Υπουργείο Εμπορίου ή στο Υπουργείο Ενέργειας. Ο φορέας αυτός θα πρέπει να απαιτεί από τους προγραμματιστές των πρωτοποριακών ΑΙ να διενεργούν αξιολογήσεις κινδύνου (risk assessments) και να αναφέρουν τα ευρήματά τους πριν εκπαιδεύσουν τα μοντέλα τους. Οι αξιολογήσεις θα παρέχουν μεγαλύτερη διαφάνεια στην ανάπτυξη και θα δίνουν την ευκαιρία στις ρυθμιστικές Αρχές να απαιτήσουν από τις εταιρείες να προσαρμόσουν τα σχέδιά τους, όπως ενισχύοντας τα μέτρα κυβερνοασφάλειας για την αποτροπή κλοπής μοντέλων.

Η αρχική αξιολόγηση κινδύνου θα είναι μόνο η εκκίνηση της εξέτασης από τις ρυθμιστικές Αρχές. Αφότου τα εργαστήρια τεχνητής νοημοσύνης εκπαιδεύσουν ένα σύστημα, αλλά πριν το αναπτύξουν, ο οργανισμός θα πρέπει να απαιτήσει από τα εργαστήρια να διεξάγουν μια άλλη ενδελεχή σειρά αξιολόγησης κινδύνου, συμπεριλαμβανομένης της δοκιμής του μοντέλου για το πόσο ελεγχόμενο είναι και τις επικίνδυνες δυνατότητες που έχει. Οι αξιολογήσεις αυτές θα πρέπει να αποστέλλονται στον ρυθμιστικό φορέα, ο οποίος στην συνέχεια θα υποβάλλει το μοντέλο στην δική του εντατική εξέταση, μεταξύ άλλων με την διεξαγωγή δοκιμών πίεσης (stress tests) από εξωτερικές ομάδες για την αναζήτηση ελαττωμάτων.

Στην συνέχεια, οι ρυθμιστικές Αρχές θα θεσπίσουν κανόνες για τον τρόπο με τον οποίο μπορεί να αναπτυχθεί το μοντέλο. Θα μπορούσαν να καθορίσουν ότι ορισμένα μοντέλα μπορούν να διατεθούν ευρέως. Ίσως να αποφασίσουν ότι άλλα είναι τόσο επικίνδυνα που δεν μπορούν να κυκλοφορήσουν καθόλου. Τα περισσότερα μοντέλα είναι πιθανό να βρίσκονται κάπου στο ενδιάμεσο: ασφαλή, αλλά μόνο με επαρκείς προστασίες. Αρχικά, ο οργανισμός θα μπορούσε να υιοθετήσει μια προσεκτική προσέγγιση, θέτοντας περιορισμούς σε μοντέλα που αργότερα αποδεικνύονται ασφαλή, αφήνοντας την κοινωνία να προσαρμοστεί στην χρήση τους και δίνοντας χρόνο στις ρυθμιστικές Αρχές να μάθουν για τις επιπτώσεις τους. Ο οργανισμός μπορεί πάντα να προσαρμόσει τους κανόνες αυτούς αργότερα, αν ένα μοντέλο αποδειχθεί ότι έχει λίγους κινδύνους. Ο οργανισμός θα μπορούσε επίσης να αποσύρει ένα σύστημα από την αγορά αν αποδειχθεί ότι είναι πιο επικίνδυνο από το αναμενόμενο. Αυτή η ρυθμιστική προσέγγιση θα αντικατοπτρίζει τον τρόπο με τον οποίο διέπονται άλλες σημαντικές τεχνολογίες, όπως η βιοτεχνολογία, τα εμπορικά αεροπλάνα, και τα αυτοκίνητα.

ΕΤΟΙΜΑΣΤΕΙΤΕ ΓΙΑ ΠΡΟΣΚΡΟΥΣΗ

Ένα αυστηρό σύστημα αδειοδότησης θα συμβάλει σε μεγάλο βαθμό στην προώθηση της ασφαλούς ανάπτυξης. Αλλά τελικά, ακόμη και οι αυστηρότεροι κανονισμοί δεν μπορούν να σταματήσουν την εξάπλωση της τεχνητής νοημοσύνης. Σχεδόν κάθε σύγχρονη τεχνολογική καινοτομία, από τα τρένα μέχρι τα πυρηνικά όπλα, έχει εξαπλωθεί πέρα από τους δημιουργούς της, και η τεχνητή νοημοσύνη δεν θα αποτελέσει εξαίρεση. Τα εξελιγμένα συστήματα θα μπορούσαν να διαδοθούν μέσω κλοπής ή διαρροών, συμπεριλαμβανομένης της τεχνητής νοημοσύνης που οι ρυθμιστικές Αρχές απαγορεύουν να κυκλοφορήσει.

Ακόμα και χωρίς την κλοπή, η ισχυρή τεχνητή νοημοσύνη είναι σχεδόν βέβαιο ότι θα διαδοθεί. Οι Ηνωμένες Πολιτείες και οι σύμμαχοί τους ίσως να ελέγχουν προς το παρόν τον προηγμένο εξοπλισμό κατασκευής τσιπ. Αλλά οι ανταγωνιστές των ΗΠΑ εργάζονται για την ανάπτυξη δικού τους εξοπλισμού κατασκευής και οι εφευρέτες ίσως να βρουν τρόπους να δημιουργήσουν τεχνητή νοημοσύνη χωρίς εξελιγμένα τσιπ. Κάθε χρόνο, το υπολογιστικό υλικό γίνεται πιο αποδοτικό από άποψη κόστους, καθιστώντας δυνατή την εκπαίδευση ισχυρότερων μοντέλων τεχνητής νοημοσύνης σε χαμηλότερη τιμή. Εν τω μεταξύ, οι μηχανικοί συνεχίζουν να εντοπίζουν τρόπους εκπαίδευσης μοντέλων με λιγότερους υπολογιστικούς πόρους. Η κοινωνία θα πρέπει τελικά να ζήσει με ευρέως διαθέσιμη, πολύ ισχυρή τεχνητή νοημοσύνη. Και τα κράτη θα πρέπει να χρησιμοποιήσουν τον χρόνο που θα κερδίσουν από την ρύθμιση για να δημιουργήσουν λειτουργικές διασφαλίσεις.

Σε κάποιο βαθμό, οι χώρες έχουν ήδη ξεκινήσει. Τα τελευταία πέντε χρόνια, ο κόσμος έχει προειδοποιηθεί για τους κινδύνους των deepfakes, και οι προειδοποιήσεις βοήθησαν να εμβολιαστούν οι κοινότητες ενάντια στις ζημιές: απλά αυξάνοντας την ευαισθητοποίηση σχετικά με τα μέσα ενημέρωσης που χειραγωγούνται από την τεχνητή νοημοσύνη, οι άνθρωποι έμαθαν να είναι επιφυλακτικοί ως προς την γνησιότητα των εικόνων. Οι επιχειρήσεις και οι κυβερνήσεις έχουν αρχίσει να προχωρούν ένα βήμα παραπέρα, αναπτύσσοντας εργαλεία που διακρίνουν ξεκάθαρα τα μέσα που δημιουργούνται με τεχνητή νοημοσύνη από το αυθεντικό περιεχόμενο. Στην πραγματικότητα, οι εταιρείες μέσων κοινωνικής δικτύωσης ήδη αναγνωρίζουν και επισημαίνουν ορισμένα είδη συνθετικών media. Αλλά ορισμένες πλατφόρμες έχουν πολιτικές που είναι πιο αδύναμες από άλλες και οι κυβερνήσεις θα πρέπει να θεσπίσουν ενιαίους κανονισμούς.

Ο Λευκός Οίκος έχει λάβει μέτρα για την δημιουργία πρακτικών σήμανσης, πείθοντας επτά κορυφαίες εταιρείες τεχνητής νοημοσύνης να θέσουν υδατογράφημα σε εικόνες, βίντεο, και προϊόντα ήχου που παράγονται αλγοριθμικά. Αλλά οι εταιρείες αυτές δεν έχουν ακόμη υποσχεθεί να αναγνωρίσουν το κείμενο που παράγεται από την ΑΙ. Υπάρχει μια τεχνική εξήγηση για το γιατί: ο εντοπισμός πεζού λόγου που έχει δημιουργηθεί με τεχνητή νοημοσύνη είναι πολύ πιο δύσκολος από όσο το κοσκίνισμα για άλλα είδη περιεχομένου που έχει δημιουργηθεί με τεχνητή νοημοσύνη. Μπορεί όμως να είναι ακόμα εφικτό, και τα κράτη και οι εταιρείες θα πρέπει να επενδύσουν στην δημιουργία εργαλείων που μπορούν να το κάνουν.

Η παραπληροφόρηση, ωστόσο, είναι μόνο ένας από τους κινδύνους της ΑΙ από τους οποίους πρέπει να προφυλαχθεί η κοινωνία. Οι ερευνητές πρέπει επίσης να μάθουν πώς μπορούν να αποτρέψουν τα μοντέλα ΑΙ από το να επιτρέψουν επιθέσεις με βιολογικά όπλα. Οι υπεύθυνοι χάραξης πολιτικής μπορούν να ξεκινήσουν με την δημιουργία κανονισμών που θα απαγορεύουν στις εταιρείες σύνθεσης DNA να αποστέλλουν αλληλουχίες DNA που σχετίζονται με επικίνδυνα παθογόνα (ή δυνητικά παθογόνα) σε μη εξουσιοδοτημένους πελάτες. Οι κυβερνήσεις θα πρέπει να υποστηρίξουν τις εταιρείες σύνθεσης DNA καθώς εργάζονται για να προσδιορίσουν ποιες γενετικές αλληλουχίες θα μπορούσαν να είναι επικίνδυνες. Και οι αξιωματούχοι ίσως να χρειαστεί να επιτηρούν συνεχώς τα λύματα ή τα αεροδρόμια για ενδείξεις νέων παθογόνων [μικροοργανισμών].

Μερικές φορές, για να δημιουργήσει αυτές τις άμυνες, η κοινωνία θα πρέπει να χρησιμοποιήσει την ίδια την τεχνητή νοημοσύνη. Οι εταιρείες σύνθεσης DNA, για παράδειγμα, θα χρειαστούν πιθανότατα προηγμένα συστήματα τεχνητής νοημοσύνης για τον εντοπισμό παθογόνων μικροοργανισμών που δεν υπάρχουν ακόμη, αλλά που η τεχνητή νοημοσύνη μπορεί να εφεύρει. Για να αποτρέψουν επικίνδυνα μοντέλα ΑΙ από το να χακάρουν υπολογιστικά συστήματα, οι εταιρείες κυβερνοασφάλειας θα μπορούσαν να χρειαστούν άλλα συστήματα ΑΙ για να βρίσκουν και να επιδιορθώνουν ευπάθειες.

Η χρήση της τεχνητής νοημοσύνης για την προστασία από την τεχνητή νοημοσύνη είναι μια τρομακτική προοπτική, δεδομένου ότι δίνει τεράστια επιρροή στα υπολογιστικά συστήματα (και στους κατασκευαστές τους). Ως αποτέλεσμα, οι προγραμματιστές θα πρέπει να ενισχύσουν την ασφάλεια των μοντέλων ΑΙ για να τα προστατεύσουν από την πειρατεία. Δυστυχώς, αυτοί οι επιστήμονες έχουν δουλειά μπροστά τους. Υπάρχουν πολυάριθμοι τρόποι χειραγώγησης των μοντέλων τεχνητής νοημοσύνης, πολλοί από τους οποίους έχουν ήδη αποδειχθεί ότι λειτουργούν.

Τελικά, θα είναι πολύ δύσκολο για την κοινωνία να συμβαδίσει με τους κινδύνους της τεχνητής νοημοσύνης, ειδικά αν οι επιστήμονες πετύχουν τον στόχο τους να δημιουργήσουν συστήματα που θα είναι εξίσου έξυπνα ή και εξυπνότερα από τους ανθρώπους. Επομένως, οι ερευνητές της ΑΙ πρέπει να διασφαλίσουν ότι τα μοντέλα τους είναι πραγματικά ευθυγραμμισμένα με τις αξίες και τα συμφέροντα της κοινωνίας. Τα κράτη πρέπει επίσης να καθιερώσουν εξωτερικούς ελέγχους και ισορροπίες -συμπεριλαμβανομένων των ρυθμιστικών οργανισμών- που θα επιτρέπουν στους αξιωματούχους να εντοπίζουν και να περιορίζουν τα επικίνδυνα μοντέλα.

ΠΡΩΤΑ Η ΑΣΦΑΛΕΙΑ

Οι δημιουργοί της τεχνητής νοημοσύνης ίσως να αντιδράσουν στην ιδέα των αυστηρών κανονισμών. Οι αυστηροί κανόνες, άλλωστε, θα επιβραδύνουν την ανάπτυξη. Οι αυστηρές προϋποθέσεις θα μπορούσαν να καθυστερήσουν ή ακόμη και να ακυρώσουν μοντέλα [αξίας] δισεκατομμυρίων δολαρίων. Και όπως και σε άλλους κλάδους, οι αυστηροί κανόνες θα μπορούσαν να δημιουργήσουν εμπόδια στην είσοδο στην αγορά, μειώνοντας την καινοτομία και συγκεντρώνοντας την ανάπτυξη της τεχνητής νοημοσύνης σε έναν μικρό αριθμό ήδη ισχυρών τεχνολογικών εταιρειών.

Όμως, πολλοί άλλοι τομείς έχουν σημειώσει τεράστια πρόοδο ενώ είναι ρυθμιζόμενοι, όπως η φαρμακευτική βιομηχανία και ο τομέας της πυρηνικής ενέργειας. Στην πραγματικότητα, η ρύθμιση κατέστησε δυνατή την υιοθέτηση πολλών κρίσιμων τεχνολογιών από την κοινωνία. (Φανταστείτε μόνο πόσο χειρότερος θα ήταν ο σκεπτικισμός για τα εμβόλια αν δεν υπήρχε ισχυρή κρατική εποπτεία). Οι κανονισμοί παρέχουν επίσης κίνητρα στις επιχειρήσεις να καινοτομούν όσον αφορά την ασφάλεια, διασφαλίζοντας ότι η ιδιωτική έρευνα είναι ευθυγραμμισμένη με τις δημόσιες ανάγκες. Και οι κυβερνήσεις μπορούν να εγγυηθούν ότι οι μικροί παίκτες συμβάλλουν στην καινοτομία της τεχνητής νοημοσύνης, παραχωρώντας τους την χρήση προηγμένων τσιπ σε υπεύθυνους ερευνητές. Στις Ηνωμένες Πολιτείες, για παράδειγμα, το Κογκρέσο σκέφτεται να δημιουργήσει έναν «Εθνικό Πόρο Έρευνας Τεχνητής Νοημοσύνης»: μια ομοσπονδιακή παροχή δεδομένων και ισχυρού υπολογιστικού υλικού προσβάσιμου σε ακαδημαϊκούς.

Αλλά το Κογκρέσο δεν μπορεί να σταματήσει εκεί -ή στον έλεγχο της ανάπτυξης της τεχνητής νοημοσύνης. Η κυβέρνηση των ΗΠΑ πρέπει επίσης να λάβει μέτρα για να προετοιμάσει την κοινωνία για τους κινδύνους της ΑΙ. Η ανάπτυξη ισχυρών συστημάτων τεχνητής νοημοσύνης είναι αναπόφευκτη και οι άνθρωποι παντού πρέπει να είναι προετοιμασμένοι για το τι θα κάνουν αυτές οι τεχνολογίες στις κοινότητές τους και στον ευρύτερο κόσμο. Μόνο τότε μπορεί η κοινωνία να αποκομίσει τα τεράστια οφέλη που μπορεί να φέρει η τεχνητή νοημοσύνη.

Σύνδεσμοι:

[1] https://wwnorton.com/books/9780393866865#!

[2] https://www.youtube.com/watch?v=g7YJIpkk7KM

[3] https://evals.alignment.org/blog/2023-08-01-new-report/

Copyright © 2023 by the Council on Foreign Relations, Inc.

All rights reserved.

Στα αγγλικά: https://www.foreignaffairs.com/world/how-prevent-ai-catastrophe-artifici...

Μπορείτε να ακολουθείτε το «Foreign Affairs, The Hellenic Edition» στο TWITTER στην διεύθυνση www.twitter.com/foreigngr αλλά και στο FACEBOOK, στην διεύθυνση www.facebook.com/ForeignAffairs.gr και στο linkedin στην διεύθυνση https://www.linkedin.com/company/foreign-affairs-the-hellenic-edition