Φονικές εφαρμογές

Η τεχνητή νοημοσύνη θα ενισχύσει την οικονομική ανάπτυξη, θα βοηθήσει στην διάγνωση και θεραπεία ασθενειών, θα μειώσει τα τροχαία ατυχήματα και θα βελτιώσει την καθημερινή ζωή των ανθρώπων με χιλιάδες τρόπους. Όπως και κάθε νέα τεχνολογία, ωστόσο, η τεχνητή νοημοσύνη έχει επίσης μια σκοτεινότερη πλευρά.

Ο PAUL SCHARRE είναι ανώτερος συνεργάτης και διευθυντής του Προγράμματος Τεχνολογίας και Εθνικής Ασφάλειας στο Center for a New American Security. Είναι ο συγγραφέας του βιβλίου με τίτλο Army of None: Autonomous Weapons and the Future of War [1].

Ακόμα και όταν δεν καταρρέουν εντελώς, τα συστήματα μάθησης μερικές φορές μαθαίνουν να επιτυγχάνουν τους στόχους τους με λάθος τρόπο. Σε μια ερευνητική εργασία [15] πέρυσι, μια ομάδα 52 ερευνητών της AI εξιστόρησαν δεκάδες φορές που τα συστήματα AI έδειξαν απρόσμενη συμπεριφορά. Ένας αλγόριθμος που μαθαίνει να περπατάει σε ένα προσομοιωμένο περιβάλλον ανακάλυψε ότι θα μπορούσε να κινηθεί ταχύτερα με το να πέφτει επανειλημμένα. Ένα bot που παίζει Tetris έμαθε να σταματά το παιχνίδι πριν πέσει το τελευταίο τούβλο, ώστε να μην χάνει ποτέ. Ένα πρόγραμμα διέγραψε τα αρχεία που περιείχαν τις απαντήσεις επί των οποίων θα αξιολογείτο, προκαλώντας έτσι την επίτευξη ενός τέλειου αποτελέσματος. Όπως έγραψαν οι ερευνητές, «Είναι συχνά λειτουργικά απλούστερο για την εξέλιξη να εκμεταλλεύεται τα κενά στην ποσοτική μέτρηση από όσο είναι το να επιτυγχάνει το πραγματικά επιθυμητό αποτέλεσμα». Η έκπληξη φαίνεται να αποτελεί τυπικό χαρακτηριστικό των συστημάτων μάθησης.

Τα συστήματα μάθησης των μηχανών είναι πάντα τόσο καλά όσο τα δεδομένα της εκπαίδευσής τους. Αν τα δεδομένα (data) δεν αντιπροσωπεύουν καλά το λειτουργικό περιβάλλον του συστήματος, το σύστημα μπορεί να αποτύχει στον πραγματικό κόσμο. Το 2018, για παράδειγμα, οι ερευνητές στο MIT Media Lab έδειξαν ότι τρία κορυφαία συστήματα αναγνώρισης προσώπου ήταν πολύ χειρότερα κατά την ταξινόμηση των σκουρόχρωμων προσώπων από όσο ήταν στην ταξινόμηση των ανοιχτόχρωμων προσώπων.

Όταν αποτυγχάνουν, τα συστήματα μηχανικής μάθησης είναι συχνά απογοητευτικά ομιχλώδη. Στα βασισμένα σε κανόνες συστήματα, οι ερευνητές μπορούν πάντα να εξηγήσουν την συμπεριφορά του μηχανισμού, ακόμα και αν δεν μπορούν πάντα να την προβλέψουν. Στα συστήματα βαθιάς μάθησης, ωστόσο, οι ερευνητές συχνά αδυνατούν να καταλάβουν γιατί μια μηχανή έκανε ό, τι έκανε. Ο Ali Rahimi, ένας ερευνητής της AI στην Google, υποστήριξε [16] ότι πάνω-κάτω όπως οι μεσαιωνικοί αλχημιστές, οι οποίοι ανακάλυψαν τις σύγχρονες τεχνικές της υαλουργίας αλλά δεν καταλάβαιναν την χημεία ή την φυσική πίσω από τις ανακαλύψεις τους, οι σύγχρονοι μηχανικοί της μηχανικής μάθησης μπορούν να επιτύχουν ισχυρά αποτελέσματα, αλλά τους λείπει η υποκείμενη επιστήμη για να τα εξηγήσουν.

Κάθε αποτυχία ενός συστήματος AI παρουσιάζει επίσης μια ευπάθεια που μπορεί να αξιοποιηθεί. Σε ορισμένες περιπτώσεις, οι επιτιθέμενοι μπορούν να δηλητηριάσουν τα δεδομένα της εκπαίδευσης. Το 2016, η Microsoft δημιούργησε ένα chatbot που το ονόμασε Tay και του έδωσε έναν λογαριασμό Twitter. Άλλοι χρήστες άρχισαν να αναρτούν προσβλητικά μηνύματα σε αυτόν, και μέσα σε 24 ώρες, ο Tay είχε αρχίσει να παπαγαλίζει την ρατσιστική και αντισημιτική γλώσσα. Στην περίπτωση αυτή, η πηγή των κακών data ήταν προφανής. Αλλά δεν είναι όλες οι επιθέσεις δηλητηρίασης δεδομένων τόσο ορατές. Κάποιες μπορούν να θαφτούν μέσα στα δεδομένα εκπαίδευσης (training data) με τρόπο που δεν μπορεί να ανιχνευθεί από τον άνθρωπο αλλά εξακολουθούν να χειραγωγούν το μηχάνημα.

Ακόμη και αν οι δημιουργοί ενός συστήματος βαθιάς εκμάθησης (deep-learning system) προστατεύουν τις πηγές των δεδομένων του, το σύστημα μπορεί ακόμα να εξαπατηθεί χρησιμοποιώντας αυτά που είναι γνωστά ως «αντιφατικά παραδείγματα» (“adversarial examples”), όπου ένας επιτιθέμενος τροφοδοτεί το σύστημα με μια εισροή που είναι προσεκτικά προσαρμοσμένη για να κάνει το μηχάνημα να προβεί σε ένα λάθος. Ένα νευρωνικό δίκτυο που ταξινομεί δορυφορικές εικόνες μπορεί να εξαπατηθεί στο να εκλάβει μια ελαφρώς αλλοιωμένη εικόνα ενός νοσοκομείου ως στρατιωτικό αεροδρόμιο ή αντίστροφα. Η αλλαγή στην εικόνα μπορεί να είναι τόσο μικρή ώστε η εικόνα να φαίνεται φυσιολογική σε έναν άνθρωπο [17], αλλά εξακολουθεί να εξαπατά την ΑΙ. Τα αντιφατικά παραδείγματα μπορούν μέχρι να τοποθετηθούν σε φυσικά αντικείμενα. Σε μια περίπτωση, οι ερευνητές δημιούργησαν μια πλαστική χελώνα με λεπτές σπείρες ενσωματωμένες στο κέλυφός της που έκανε ένα σύστημα ταυτοποίησης αντικειμένων να θεωρεί ότι επρόκειτο για τουφέκι. Σε ένα άλλο [18], οι ερευνητές τοποθέτησαν μια χούφτα μικρών λευκών και μαύρων τετραγώνων σε μια πινακίδα stop, προκαλώντας ένα νευρωνικό δίκτυο να την ταξινομήσει ως πινακίδα ταχύτητας 45 μιλίων ανά ώρα. Για να χειροτερέψουν τα πράγματα, οι επιτιθέμενοι μπορούν να αναπτύξουν αυτά τα είδη παραπλανητικών εικόνων και αντικειμένων χωρίς πρόσβαση στα δεδομένα εκπαίδευσης ή στον υποκείμενο αλγόριθμο του συστήματος που προσπαθούν να νικήσουν, και οι ερευνητές έχουν αγωνιστεί για να βρουν αποτελεσματικές άμυνες κατά της απειλής. Σε αντίθεση με τα τρωτά σημεία της κυβερνοασφάλειας, τα οποία συχνά μπορούν να διορθωθούν όταν αποκαλυφθούν, δεν υπάρχει γνωστός τρόπος πλήρους ανοσοποίησης των αλγορίθμων κατά των επιθέσεων αυτών.

Οι κυβερνήσεις έχουν ήδη μεγάλη εμπειρία δοκιμής σε στρατιωτικά, κυβερνο-επιχειρησιακά και επιτηρητικά εργαλεία, αλλά καμία μέθοδος δοκιμής δεν μπορεί να εγγυηθεί ότι τα πολύπλοκα συστήματα δεν θα βιώσουν δυσλειτουργίες όταν βγουν έξω στον πραγματικό κόσμο. Την πρώτη φορά που τα μαχητικά αεροσκάφη F-22 διέσχισαν την Διεθνή Γραμμή Ημερομηνίας (International Date Line, IDL), οι υπολογιστές τους κατέρρευσαν και τα αεροσκάφη είχαν σχεδόν απομονωθεί πάνω από τον Ειρηνικό Ωκεανό.

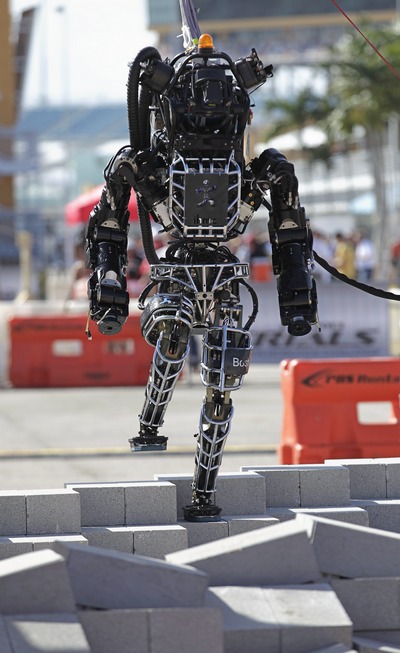

Το Atlas της Boston Dynamics, ένα ανθρωποειδές ρομπότ, κατά την διάρκεια άσκησης στο Homestead της Φλόριντα, τον Δεκέμβριο του 2013. Andrew Innerarity / REUTERS

----------------------------------------------------